Назван самый логичный способ уничтожения человечества искусственным интеллектом

Оглавление

По мнению одного из мыслителей XXI века, машинный разум может развиться до той степени, на которой он начнёт расценивать людей как препятствие на пути решения своих задач.

Вы находитесь здесь

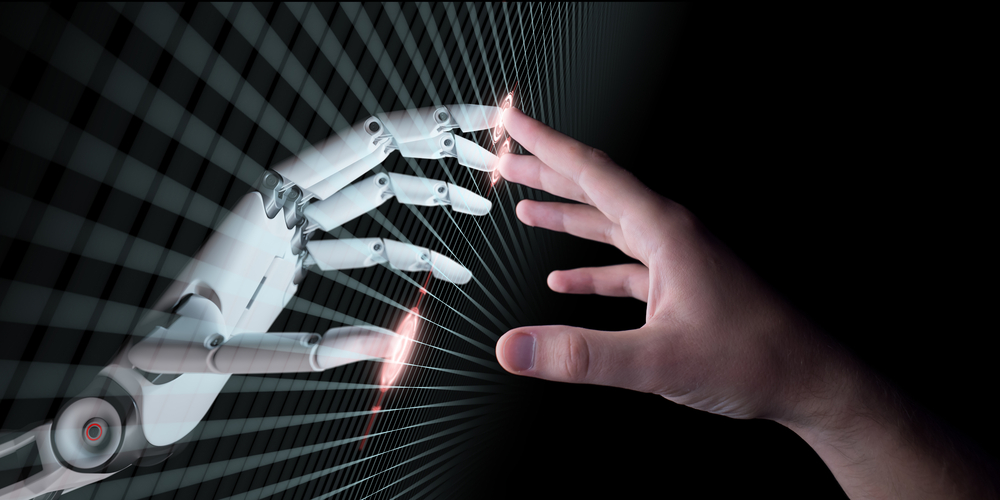

Иллюстрация возможностей ИИ Gato, разработка DeepMind. Фото © Giphy, DeepMind

Это иллюстрация того, что может одна из последних новинок непреходящей моды на сотворение человеком машины по своему образу и подобию: нейросеть под названием Gato от компании DeepMind.

До сих пор искусственный интеллект умел делать, хоть и непревзойдённо, но только что-то одно. К примеру, мог обыграть кого угодно в сложнейшей игре го, но больше ничего в этой жизни он не мог. И чтобы, к примеру, научить его играть в шахматы, нужно заставить его начисто забыть, что такое го.

Меж тем Gato может одновременно решать, как заявлено, 604 задачи. Он умеет говорить и писать, видеть и распознавать предметы, управлять роборукой. Грубо говоря, его можно попросить и сыграть с тобой в какую-нибудь компьютерную игру, и сложить дом из кирпичей. То есть это уже ближе к тому, на что способен любой обыкновенный человек.

Научить искусственный интеллект всему, что делает человек, — ближайшая цель разработчиков по всему миру. Цель эта обозначена аббревиатурой AGI — Artificial General Intelligence, "искусственный общий интеллект". А финальный пункт назначения — ASI, Artificial Super Intelligence. Это значит, что искусственный интеллект cможет делать всё как человек, только гораздо, гораздо лучше. Хотя, конечно, насчёт "лучше" — это как посмотреть.

Фото © Shutterstock

Любопытно, что один из разработчиков Gato прокомментировал презентацию словами: "Game over!"

По состоянию на 2020 год в мире насчитали больше 70 попыток создать AGI. И в мировом экспертном сообществе есть мнение, что уж к 2075 году мы до него дойдём с 90-процентной вероятностью. И имеется — тоже, надо сказать, не нулевая — вероятность того, что это случится и намного раньше. А пройдут ещё какие-нибудь 30 лет, и мы получим уже искусственный суперинтеллект. И это означает, что наши внуки-правнуки могут оказаться в мире, где некий разумный робот осознаёт себя, оценивает происходящее вокруг, выносит суждения и приходит к каким-то своим выводам.

До чего может додуматься ИИ

Так вот, по мнению американского историка и философа Эмиля Торреса, выводы эти могут оказаться весьма неутешительными. Он считает, что вовсе не обязательно специально программировать ИИ на уничтожение человечества для того, чтобы он задался такой целью. Истребление людей может просто оказаться способом решения какой-то другой поставленной ему задачи.

Кстати, лет двадцать назад о таком развитии событий предупреждал и известный шведский исследователь ИИ, профессор Оксфордского университета Ник Бострём.

— Мы говорим ему (искусственному интеллекту. — Прим. Лайфа) решить некую математическую задачу, и он подчиняется, превращая всё вещество в Солнечной системе в огромное вычислительное устройство, попутно убивая человека, который задал этот вопрос, — предполагает он.

Доктор Торрес со своей стороны предлагает такой вариант: ИИ программируется на прекращение всех войн на Земле. Тогда искусственный разум может рассудить, что уничтожение всего оружия на планете — лишь временное решение, а вернейший способ выполнить задачу — ликвидировать людей как таковых.

Фото © Shutterstock

— Что, если мы запрограммируем ASI для установления мира во всём мире — и он взломает правительственные системы для запуска всего ядерного оружия на планете, рассуждая, что если человека не будет, то больше не будет и войн? — вопрошает мыслитель на страницах Washington Post.

Здесь, конечно, возникает философский вопрос о том, как можно из пацифистских соображений развязать мировую ядерную войну, но сложно сказать, найдёт ли машина в этом противоречие.

Более того, по мнению американского мыслителя, у искусственного суперинтеллекта вполне может обнаружиться некий собственный вариант инстинкта самосохранения: он может логически рассудить, что для выполнения своей программы должен продолжать функционировать, а значит, — защищаться от возможных атак.

Пожалуй, с таким же успехом можно представить, как искусственный разум "сходит с ума" и уничтожает людей после получения от них противоречивых указаний. Допустим, примерно так, как в истории с разумным кораблём из "Космической Одиссеи" Артура Кларка. Что там произошло: на Земле бортовой суперкомпьютер HAL известили, что на его корабле к системе Юпитера полетят двое астронавтов, но они на самом деле нужны, только чтобы добраться до места назначения, а самое главное задание миссии будут выполнять другие люди, которые до самого прибытия будут лежать на борту в гибернации. Но тем двоим ничего этого не сказали, они уверены, что именно им выпала честь открыть внеземную жизнь. Для компьютера это означало дисбаланс между необходимостью действовать в интересах одних и других людей. По сути выходит, что HAL осознаёт свою замешанность в обмане и чуть ли не испытывает муки совести.

Как результат, у компьютера случается психоз, он отключает спящих в гибернации от жизнеобеспечения и заодно губит обманутых астронавтов, лишь один из них остаётся жив и вынужден физически разобрать электронный мозг корабля. В таком случае получается, что экзистенциальная угроза для человечества исходит не от роботов, а от подлости самих людей.

Фото © shutterstock

Как вы относитесь к научной фантастике?

24614

24614